Das Deutsche GeoForschungsZentrum (GFZ) ist das nationale Forschungszentrum für Geowissenschaften in Deutschland. Es befindet sich im Wissenschaftspark Albert Einstein auf dem Potsdamer Telegrafenberg. Das GFZ umfasst alle Disziplinen der Geowissenschaften von der Geodäsie bis zum Geoingenieurwesen und betreibt sie in einem engen interdisziplinären Verbund mit den benachbarten Naturwissenschaften Physik, Mathematik und Chemie sowie den ingenieurwissenschaftlichen Disziplinen Felsmechanik, Ingenieurhydrologie und Ingenieurseismologie. Damit ist das Institut bestens aufgestellt, um sich fundiert und ausgewogen an der aktuellen Klimadebatte zu beteiligen.

Das Deutsche GeoForschungsZentrum (GFZ) ist das nationale Forschungszentrum für Geowissenschaften in Deutschland. Es befindet sich im Wissenschaftspark Albert Einstein auf dem Potsdamer Telegrafenberg. Das GFZ umfasst alle Disziplinen der Geowissenschaften von der Geodäsie bis zum Geoingenieurwesen und betreibt sie in einem engen interdisziplinären Verbund mit den benachbarten Naturwissenschaften Physik, Mathematik und Chemie sowie den ingenieurwissenschaftlichen Disziplinen Felsmechanik, Ingenieurhydrologie und Ingenieurseismologie. Damit ist das Institut bestens aufgestellt, um sich fundiert und ausgewogen an der aktuellen Klimadebatte zu beteiligen.

In den vergangenen Monaten haben wir bereits zwei wichtige Forschungsarbeiten mit GFZ-Beteiligung hier im Blog vorgestellt. So berichteten wir im April 2012 über eine Studie zur Klimageschichte des Aralsees, die ergab, dass sich im Laufe der letzten zwei Jahrtausende trockene, staubige Phasen stets mit feuchteren, weniger staubigen Phasen im Takte der Temperatur- und Sonnenaktivitätsentwicklung abwechselten (siehe unser Blogartikel „Starke Sonne drängt den Staub am Aralsee zurück: Feuchtere Zeiten während Wärmeperioden“). Im Mai 2012 stellten wir dann GFZ-Forschungsergebnisse zu einer Kältephase vor 2800 Jahren vor, die durch geringe Sonnenaktivität ausgelöst wurde (siehe unser Blogartikel „Geoforschungszentrum Potsdam: Solarflaute vor 2800 Jahren löste Kälteperiode in Mitteleuropa aus“).

Im Juli 2012 erschien nun eine bemerkenswerte Sonderpublikation des GFZ in Zusammenarbeit mit Bild der Wissenschaft, die den Titel „Klimawandel: Was wissen wir wirklich?“ trägt. Im Folgenden wollen wir einige ausgewählte Passagen aus dieser Schrift zitieren. Das gesamte Heft kann über den Leserservice von Bild der Wissenschaft (leserservice@wissenschaft.de) bezogen werden.

Auszüge aus dem Vorwort von Prof. Reinhard Hüttl, Wissenschaftlicher Vorstand und Vorstandsvorsitzender des Deutschen GeoForschungsZentrums GFZ:

Wer die Welt in die Kategorien Schwarz und Weiß aufteilt, liegt zwangsläufig falsch. Denn zwischen diesen beiden Extremen gibt es nicht nur einige, sondern beliebig viele Graustufen. Diese uralte Erkenntnis trifft auch auf die Klimaforschung zu. […] Da gibt es auf der einen Seite die sogenannten Klimaskeptiker […]. Das andere Extrem sind diejenigen, die in lebhaften Farben Katastrophen zeichnen […]. Wie so oft liegt die Realität zwischen den Extremen. […]

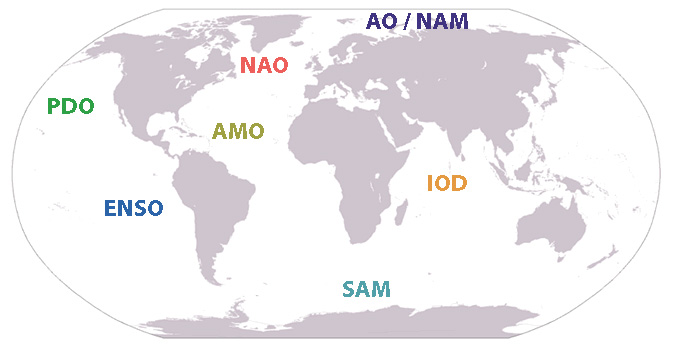

Das Klima ist auch eng verknüpft mit den verschiedenen Teilsystemen der Erde, von den Strömungen in den Weltmeeren über die Vegetation an der Erdoberfläche bis hin zu den Vorgängen im Erdinneren. Zudem ist unsere Erde ein Planet und unterliegt wichtigen extraterrestrischen Einflüssen, und dies gilt in besonderem Maße für das Klima. […]

Das [Klima] ändert sich auch, wenn der Mensch nicht mitwirkt. Klimamodelle können dieses komplizierte System daher nicht beschreiben – an sich benötigen wir modellhafte Abbildungen des gesamten Erdsystems. Aber auch damit ließe sich das Klima nicht planen, sondern allenfalls könnten wir seine Dynamik besser abschätzen. So wissen wir auch nicht exakt, welchen Anteil der Mensch am aktuellen Klimawandel hat und welcher Anteil den natürlichen Klimafaktoren zukommt.

Vor einigen Tagen unterbrach das führende klimaskeptische Blog Watts Up With That? (WUWT) seine sonst so emsige Tätigkeit. Wo im Normalbetrieb jeden Tag eine ganze Hand voll neuer Blogartikel erschienen, herrschte plötzlich lähmende Inaktivität. Der Betreiber der Webseite, der Meteorologe Anthony Watts, kündigte eine wichtige Pressemitteilung für den Abend des 29. Juli europäischer Zeit an. Die Gerüchteküche brodelte und die Vermutungen gingen in die verschiedensten Richtungen. Hoffentlich handelte es sich nicht um Anthony’s Gesundheit. Waren es vielleicht juristische Vorgänge im Hintergrund, die WUWT zum Stop zwangen? Nein, keines von beidem, beruhigte Anthony die Blogosphäre vorab. Aber man müsse noch Geduld haben.

Vor einigen Tagen unterbrach das führende klimaskeptische Blog Watts Up With That? (WUWT) seine sonst so emsige Tätigkeit. Wo im Normalbetrieb jeden Tag eine ganze Hand voll neuer Blogartikel erschienen, herrschte plötzlich lähmende Inaktivität. Der Betreiber der Webseite, der Meteorologe Anthony Watts, kündigte eine wichtige Pressemitteilung für den Abend des 29. Juli europäischer Zeit an. Die Gerüchteküche brodelte und die Vermutungen gingen in die verschiedensten Richtungen. Hoffentlich handelte es sich nicht um Anthony’s Gesundheit. Waren es vielleicht juristische Vorgänge im Hintergrund, die WUWT zum Stop zwangen? Nein, keines von beidem, beruhigte Anthony die Blogosphäre vorab. Aber man müsse noch Geduld haben.

Die Orkneys sind ein aus ca. 100 kleineren Inseln und einer Hauptinsel bestehender zu Schottland gehörender Archipel. Durch den warmen Golfstrom kann man es dort gut aushalten. Das dachten sich wohl auch die Wikinger, die etwa 780 n. Chr. von Skandinavien herübergeschippert kamen und für einige hundert Jahre das Kommando auf den Orkneys übernahmen. Ganz besonders schienen die rauhen Gesellen Fisch und Napfschnecken zu mögen, welche Archäologen massenhaft in den wikingischen Müllhaufen fanden.

Die Orkneys sind ein aus ca. 100 kleineren Inseln und einer Hauptinsel bestehender zu Schottland gehörender Archipel. Durch den warmen Golfstrom kann man es dort gut aushalten. Das dachten sich wohl auch die Wikinger, die etwa 780 n. Chr. von Skandinavien herübergeschippert kamen und für einige hundert Jahre das Kommando auf den Orkneys übernahmen. Ganz besonders schienen die rauhen Gesellen Fisch und Napfschnecken zu mögen, welche Archäologen massenhaft in den wikingischen Müllhaufen fanden.

In Bayern hat es dieses Jahr bereits 93.208 Mal geblitzt, meldete die Süddeutsche Zeitung am 10.7.2012. Schuld daran könnte doch eigentlich nur die Klimakatastrophe sein, möchte man meinen. Nichts da, sagt die SZ und gibt Entwarnung:

In Bayern hat es dieses Jahr bereits 93.208 Mal geblitzt, meldete die Süddeutsche Zeitung am 10.7.2012. Schuld daran könnte doch eigentlich nur die Klimakatastrophe sein, möchte man meinen. Nichts da, sagt die SZ und gibt Entwarnung: