Die Mittelalterliche Wärmeperiode ist so eine ganz seltsame Sache. Sie ereignete sich vor 1000 Jahren und wurde einige hundert Jahre später von der Kleinen Eiszeit abgelöst. Und danach folgte die Modern Wärmeperiode (MWP), in der wir uns heute befinden. Das interessante an der Mittelalterlichen Wärmeoperiode ist nun, dass es damals genauso warm war wie heute – und das obwohl der CO2-Gehalt der Atmosphäre sehr niedrig auf vorindustriellem Niveau war. Was könnte die Temperaturen damals so aufgeheizt haben? Die Sonne kann es ja nicht gewesen sein, sagt der Weltklimarat. Laut den Formeln kann sie keine signifikanten Temperaturhebungen verursachen. Seltsamerweise war die Sonne zu genau dieser Zeit aber besonders aktiv. Nur ein dummer Zufall? Ein düsterer Gedanke schießt durchs Hirn: Könnte es sein, ja könnte es sein, dass die IPCC-Modelle die Sonne nicht richtig abbilden? Irgendwann werden die Kollegen vom Weltklimara vermutlich selber drauf kommen. Bis dahin wollen wir ein bisschen mithelfen und im folgenden neue Fallstudien zur Mittelalterliche Wärmeperiode (MWP) weltweit kurz zusammenfassen:

Die Mittelalterliche Wärmeperiode ist so eine ganz seltsame Sache. Sie ereignete sich vor 1000 Jahren und wurde einige hundert Jahre später von der Kleinen Eiszeit abgelöst. Und danach folgte die Modern Wärmeperiode (MWP), in der wir uns heute befinden. Das interessante an der Mittelalterlichen Wärmeoperiode ist nun, dass es damals genauso warm war wie heute – und das obwohl der CO2-Gehalt der Atmosphäre sehr niedrig auf vorindustriellem Niveau war. Was könnte die Temperaturen damals so aufgeheizt haben? Die Sonne kann es ja nicht gewesen sein, sagt der Weltklimarat. Laut den Formeln kann sie keine signifikanten Temperaturhebungen verursachen. Seltsamerweise war die Sonne zu genau dieser Zeit aber besonders aktiv. Nur ein dummer Zufall? Ein düsterer Gedanke schießt durchs Hirn: Könnte es sein, ja könnte es sein, dass die IPCC-Modelle die Sonne nicht richtig abbilden? Irgendwann werden die Kollegen vom Weltklimara vermutlich selber drauf kommen. Bis dahin wollen wir ein bisschen mithelfen und im folgenden neue Fallstudien zur Mittelalterliche Wärmeperiode (MWP) weltweit kurz zusammenfassen:

EUROPA

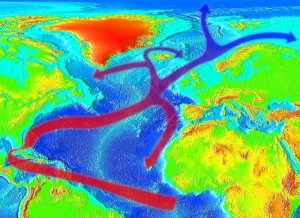

Atlantik

Maximale Wassertemperaturen lagen während der MWP im nordöstlichen Atlantik mehr als 2°C höher als gegen Ende des 20 Jahrhunderts. Dies ergab eine Studie von Richter et al. die 2009 in den Quaternary Science Reviews erschien.

Großbritannien

Donna Surge und James Barrett untersuchte die Temperaturgeschichte der schottischen Orkneyinseln. Zu ihrer Überraschung fanden sie, dass die Temperaturen während der MWP um etwa 1°C höher lagen als im späten 20. Jahrhundert. Die Studie erschien im Juli 2012 in Palaeogeography, Palaeoclimatology, Palaeoecology. Siehe auch Berichte auf kaltesonne und The Hockey Schtick.

Norwegen

Temperaturrekonstruktionen aus Spitzbergen und Nord-Norwegen ergaben, dass die Temperaturen dort während der MWP deutlich höher lagen als heute. Divine et al. veröffentlichten ihre Studie 2011 im Fachjournal Polar Research.

Zu ähnlichen Ergebnissen kam auch ein Team um Jan Esper von der Johannes Gutenberg University in Mainz. Ihre Untersuchungen zeigten, dass die Sommer in Nordskandinavien während der MWP wohl ähnlich warm oder sogar wärmer als heute waren. Die Arbeit erschien im Januar 2012 in der Zeitschrift Global and Planetary Change.

Schweden

In Schweden hat Keith Briffa mit Kollegen die Mittelalterliche Wärmeperiode (MWP) wiedergefunden. Im Oktober 2012 erschien in der Zeitschrift The Holocene eine neue Arbeit hierzu. Die Temperaturen während der MWP waren damals genau so hoch wie heute. Siehe auch Beitrag auf WUWT.

Schweiz

Eine Studie des schweizerischen Seebergsees kommt zu dem Schluss:

Die mittlere Juli-Temperatur war gegen Ende der Mittelalterlichen Wärmeperiode etwa 1,2°C wärmer als im 20. Jahrhundert.

Die Arbeit erschien im April 2012 in den Quaternary Science Reviews. Siehe auch Bericht des NIPCC.

Spanien

Auf der Iberischen Halbinsel war die MWP durch außergewöhnlich trockene Bedingungen gekennzeichnet. Dies ergab eine Studie eines spanischen Forscherteams, das seine Ergebnisse im Juni 2012 in den Quaternary Science Reviews veröffentlichte.

AMERIKA

Bahamas

Gegen Ende der MWP war es auf den Bahamas schon einmal so warm wie heute. Dies fanden Saenger et al., die ihre Ergebnisse 2009 in Nature Geoscience veröffentlichten.

Erinnern Sie sich? Im Herbst 2011 wurden der Öffentlichkeit mit großem Medienaufwand vier wissenschaftliche Manuskripte einer Forschergruppe der kalifornischen Universität Berkeley präsentiert. Das Team um den Physiker Richard Muller nennt sich das „BEST“-Team, wobei BEST für Berkeley Earth Surface Temperature steht. Dabei wollte man dem Team-Namen gerecht werden und die „beste“ Analyse aller historischen Temperaturmessdaten durchführen, die es je gegeben hat. Die BEST-Forscher nahmen sich also alle verfügbaren Daten und begannen zu sortieren, zu bewerten und zu korrigieren. Am Schluss stellte sich heraus: Ja, die die bisher verwendeten offiziellen Kurven waren ok gewesen. Den städtischen Wärmeinseleffekt gibt es zwar, aber er ist auf so kleine Flächen auf der großen Erde verteilt, dass er im Großen und Ganzen keine Rolle spielt.

Erinnern Sie sich? Im Herbst 2011 wurden der Öffentlichkeit mit großem Medienaufwand vier wissenschaftliche Manuskripte einer Forschergruppe der kalifornischen Universität Berkeley präsentiert. Das Team um den Physiker Richard Muller nennt sich das „BEST“-Team, wobei BEST für Berkeley Earth Surface Temperature steht. Dabei wollte man dem Team-Namen gerecht werden und die „beste“ Analyse aller historischen Temperaturmessdaten durchführen, die es je gegeben hat. Die BEST-Forscher nahmen sich also alle verfügbaren Daten und begannen zu sortieren, zu bewerten und zu korrigieren. Am Schluss stellte sich heraus: Ja, die die bisher verwendeten offiziellen Kurven waren ok gewesen. Den städtischen Wärmeinseleffekt gibt es zwar, aber er ist auf so kleine Flächen auf der großen Erde verteilt, dass er im Großen und Ganzen keine Rolle spielt.