Von Frank Bosse und Fritz Vahrenholt

Die Energieversorgerin unseres Planetensystems verharrt weiter im Minimum der Fleckenaktivität. So langsam wird es sehr ungewöhnlich, was sich da nicht tut. Die festgestellte SSN (für SunSpotNumber) als Durchschnittszahl der Tage über den Monat, betrug 0,5. An ganzen vier von 30 Tagen gab es überhaupt nur einzelne Fleckchen zu sehen, an allen anderen Tagen war die Sonne blank.

Seit 26 Monaten ging die SSN nicht mehr über 20, so lange dauert das Minimum schon an. Ähnlich lange Perioden mit Werten unter SSN=20 sehen wir in den historischen Aufzeichnungen nur vom SC (für Solar Cycle) 14 in den Jahren 1911-13 mit 27 Monaten und vom SC 5 (1809/10) mit 24 Monaten Dauer. Wir bewegen uns auf das längste Minimum mit ausgesprochen geringer Aktivität im historischen Kontext zu! Sollte es noch weitere 8 Monate anhalten, wie von uns hier vermutet, so wird es das signifikant niedrigste Minimum in der systematisch beobachteten Geschichte seit 1750 werden. Die lange „Bettruhe“ der Sonne schlägt sich graphisch nieder:

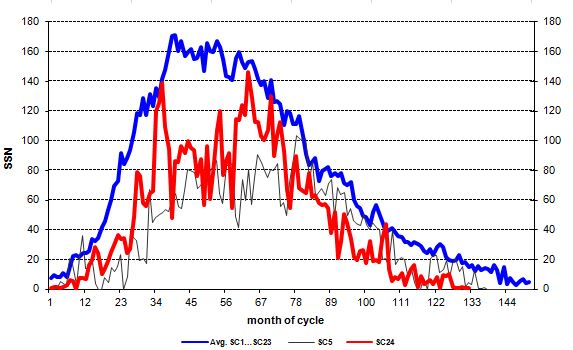

Abb.1: Der Verlauf der Fleckenaktivität über den aktuellen Zyklus 24 (rot) im Vergleich zu einem mittleren Zyklus als arithmetischer Mittelwert aller bisher beobachteten Zyklen (blau) und dem über lange Zeiträume recht ähnlichen Zyklus 5 ( schwarz).

Interessant: nur in einem einzigen Monat übertraf der Zyklus 24 den langjährigen Mittelwert der Aktivität: das war der Monat 106 des Zyklus, der September 2017. Im Nachhinein wissen wir: es war wie ein Crescendo vor der großen Stille des Minimums. Der Vergleich der Zyklen untereinander:

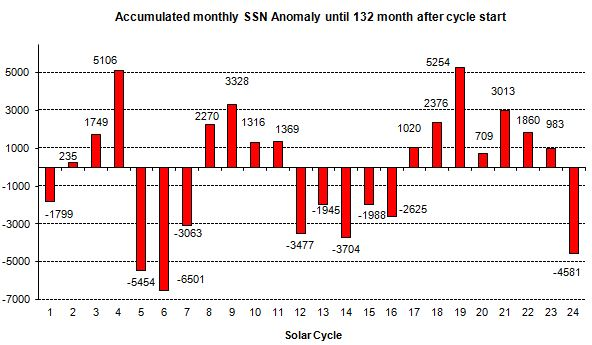

Abb. 2: Die einzelnen systematisch beobachteten Zyklen mit ihrer Aktivität. Die Zahlen entstehen, indem die monatlichen Abweichungen der Daten vom Mittelwert (blau in Abb.1) bis zum aktuellen Zyklusmonat 132 des SC24 aufaddiert werden.

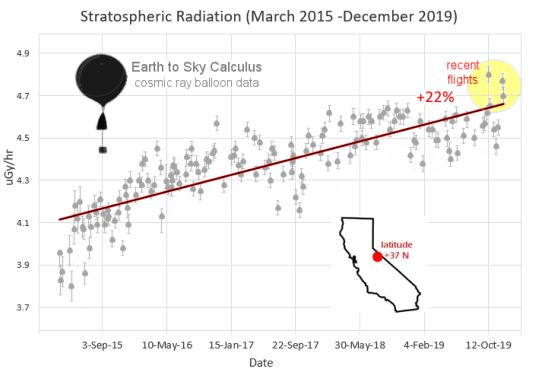

Die Säule ganz rechts wächst und wächst nach unten, im letzten Monat kamen wieder rund 15 Zähler hinzu. Die zeitnahen Auswirkungen solch niedriger Aktivität sehen wir im Anwachsen der galaktischen Strahlung vor allem in größeren Höhen. Die Strahlung wird bei stärkerer Sonnenaktivität von uns fern gehalten, die Heliosphäre reicht weiter in den Raum hinaus und schirmt auch die Erde effektiver ab. In der Stratosphäre wird seit März 2015 (Monat 76 des Zyklus zur Einordnung des Zeitpunktes in Abb.1) die Röntgen- und Gammastrahlung homogen gemessen:

Abb. 3: Das Anwachsen der Höhenstrahlung bei fallender Sonnenaktivität. Die Steigerung beträgt schon 22% bis zum aktuellen Zeitpunkt. Quelle

Ein Ende des Minimums ist weiterhin nicht in Sicht. Auch bei höherer Auflösung in der Beobachtung der Sonne wurden nur ganze 4 Mini-Spots im Laufe des Novembers verzeichnet, die man dem neuen Zyklus 25 zurechnen muss. Das ist noch kein Zeichen für ein baldiges Anlaufen des neuen Zyklus. Wir halten Sie weiter auf dem Laufenden über den „Sonnenschlaf“.

Alte Modelle verfeinert-jetzt zeigt sich ihre Nutzlosigkeit umso mehr

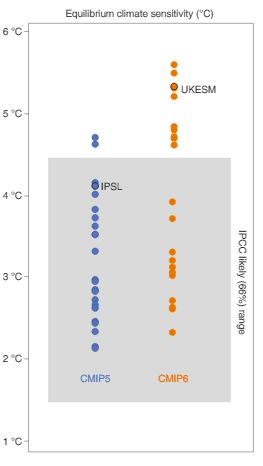

Für jeden Sachstandbericht des IPCC werden die zu verwendenden Modelle verfeinert. Die letzte Generation nannte sich CMIP5 für „Coupled Model Intercomparison Project“ für den 5. Bericht, das war 2013. Nun also wurden, etwas verspätet, von den verschiedenen Modellierungsgruppen in aller Welt die älteren Modelle nach den aktuellsten Wissensständen neu gebaut, verfeinert mit neueren Eingangsdaten, neuen Kalibrierungen aber auch neuen „Tuning“- Maßnahmen. Die veröffentlichten begutachteten Arbeiten für den kommenden Bericht (in 2021) lassen einen schon erschauern. Die Klimasensitivität (also die Erwärmung am Boden bei Verdopplung des CO2- Anteils in der Atmosphäre) ging nochmals nach oben. Eine Zusammenfassung veröffentlichten Autoren um Piers Forster unlängst. Der Titel „Neue Klima Modelle bestätigen die Notwendigkeit dringender Vorsorge“ soll nicht allzu sehr abschrecken, es ist leider der politisierte Einfluss von „Nature“, der solche Alarm- Titel präferiert. Wir lesen tiefer und staunen immer mehr. Zunächst die Feststellung der gesteigerten Sensitivität in CMIP6 im Bild:

Abb. 4: Die Entwicklung der ECS ( globale Erwärmung nach Verdopplung des CO2- Gehaltes bis zum Gleichgewicht auch in den Ozeanen) der einzelnen älteren Modelle (blau) und der neueren (orange). Überschritten nur zwei der CMIP5-Modelle den „wahrscheinlichen Bereich“ des IPCC, der nicht nur durch Modelle bestimmt ist, so tun das nun deren acht. Das Mittel sollte gut und gerne von 3 auf über 3,5°C gestiegen sein. Quelle: Fig. 1 aus Forster et al ( 2019).

Gleich unter dem Bild findet man diesen Text in der Arbeit:

„However, the higher values seen in CMIP6 are not supported by other lines of evidence and may eventually be proven wrong”.

Man staunt nicht schlecht: Höhere Werte als die vom älteren Sachstandbericht werden von anderen Untersuchungen nicht gestützt und sich letztendlich wohl als falsch erweisen! Weiter zum Ende der Arbeit hin folgen weitere unmissverständliche Worte:

„As we have shown that raw projections of surface temperature from CMIP6 should not be used directly in creating policy related to achieving temperature targets, a way of translating the model results to improve their policy relevance is needed. “

Implizit steht da: Die Modelle sollten nicht für politische Schlussfolgerungen über die Erreichung von Temperaturzielen verwendet werden. Das sind doch mal offene Worte!

Und anders herum: im letzten Sachstandbericht lag die mittlere ECS der Modelle bei 3°C und war (vgl. Abb. 4) schon etwas unsymmetrisch im grauen Bereich zu höheren Werten hin verschoben. Die empirisch wahrscheinlichste ECS von etwa 1,8 lag außerhalb des Horizontes jeden Modells. Nun also das Modell-Mittel bei etwa 3,5°C. Dieses Hochsetzen um 17% veranlasst nun kompetente Wissenschaftler an den Modellen endgültig so zu zweifeln, dass sie von ihrer Verwendung beim Abschätzen der globalen Temperaturen am Boden abraten. Ein kleiner Fortschritt!

Die vielen Rechenkapazitäten, die vielen Mannstunden an Entwicklung und der gigantische „CO2- Fußabdruck“ dieser Arbeit- für die Katz. Es zeigt sich, dass die Gläubigkeit an bisherige Modelle in der Klimawissenschaft ein Irrweg ist. In dieses Horn bläst auch eine andere, ebenfalls recht aktuelle Arbeit von Tim Palmer und Björn Stevens von der Universität Oxford bzw. vom MPI Hamburg. Sie sind klar in ihren Aussagen:

„What we find more difficult to talk about is our deep dissatisfaction with the ability of our models to inform society about the pace of warming, how this warming plays out regionally, and what it implies for the likelihood of surprises.”

Sie sind zutiefst unbefriedigt über die Möglichkeiten der Klimamodelle die Gesellschaft über relevante Fragen der Erwärmung zu informieren. Später veranschaulichen die Autoren es in einem Bild, sie benutzen hier CMIP5- Modelle:

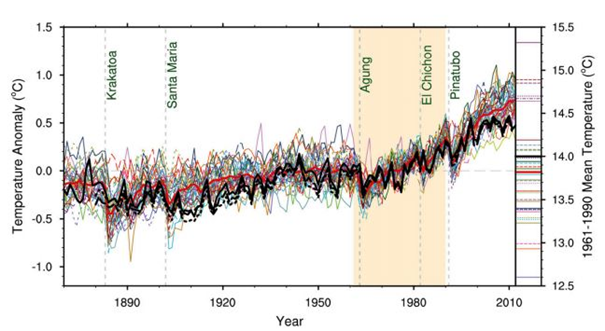

Abb.5: Die Modellsimulationen des 5. Sachstandberichtes (IPCC AR5). Quelle: Fig.1 aus Palmer/Stevens (2019). Kommuniziert wurde damals, dass die Modelle den Temperaturverlauf recht gut nachvollziehen. Es ist „das verschwommene Auftreten des Klimawandels“, so die Autoren.

Was jedoch nicht gesagt wurde, macht die rechte Ordinate deutlich, auch hier lassen wir die Autoren zu Worte kommen:

„Even after being tuned to match observed irradiance at the top of the atmosphere, models differ among themselves in their estimates of surface temperature by an amount that is 2 to 3 times as large as the observed warming and larger yet than the estimated 0.5 °C uncertainty in the observations. The deemphasis of this type of information, while helpful for focusing the reader on the settled science, contributes to the impression that, while climate models can never be perfect, they are largely fit for purpose.”

Das Unterdrücken in der Kommunikation der schweren Mängel der Klimamodelle (sie können beispielsweise hier die tatsächliche Oberflächentemperatur trotz „Tuning“ nicht im geforderten Maße abbilden)sollte den Eindruck erwecken, dass die Wissenschaft abgeschlossen ist und dass die Modelle gut genug sind, um mit ihnen zu arbeiten.

Sie waren es in Wahrheit damals nicht und sind es heute umso weniger! Das ist die Kernaussage von Palmer & Stevens. Die Autoren fordern gänzlich neue Modelle, die ihren gedachten Zweck auch erfüllen. Das macht nur Sinn, wenn man den Unsinn der bestehenden Modelle überwinden will. Besser als sie können wir es nicht ausdrücken:

„The sooner we depart from the present strategy, which overstates an ability to both extract useful information from and incrementally improve a class of models that are structurally ill suited to the challenge, the sooner we will be on the way to anticipating surprises, quantifying risks, and addressing the very real challenge that climate change poses for science.”

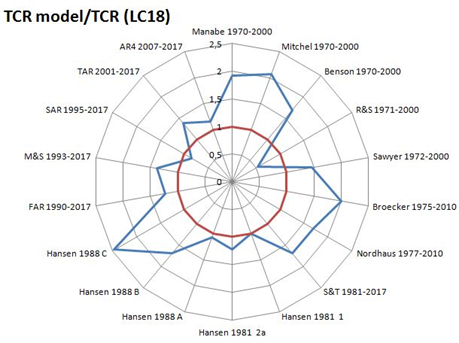

Die inkrementelle “Verbesserung” strukturell kranker Modelle ist ein Irrweg. Die bisher (und gegenwärtig) benutzten Modelle sind nutzlos, sie sind strukturell ungeeignet, irgendetwas von Bedeutung über unser Klimasystem auszusagen. Da hilft es auch nicht, wenn in einer neueren Arbeit des Lead-Autors Zeke Hausfather versucht wird, den Nachweis zu führen, dass ältere Modelle der 70er und 80er Jahre die Temperaturentwicklung bis in die 2010er gut antizipierten. Der Vergleich der Größe „TCR“ (Transient Climate Response für die Temperaturerhöhung, die sich ohne Ausgleich der Ozeane bei Verdopplung des CO2- Gehaltes der Atmosphäre einstellt) in Fig. 2 (unten) der Arbeit zeigt es. Wenn man wie da zu kurze Zeiträume hernimmt um Beobachtungen und Modellwerte gegenüberzustellen, vernachlässigt man die Unsicherheiten. Bei Berücksichtigung genügend langer Zeitspannen ermittelt sich die tatsächlich beobachtete TCR zu ca. 1,3°C und der Vergleich mit den Modellwerten stellt sich dann ganz anders dar:

Abb. 6: Die in Hausfather et. al (2019) betrachteten Modell-TCR’s (blau)im Verhältnis zur wahrscheinlichsten TCR aus Beobachtungen (Lewis/Curry 2018) in rot.

Bei näherer Betrachtung erkennt man in Abb.6, dass sehr viele frühe Modelle deutlich jenseits des roten Kreises liegen- sie sind zu empfindlich (im Mittel um den Faktor ≈1,5), bilden die Wirklichkeit auch zu warm ab. Das ist die wahre Botschaft von Hausfather et al (2019).

Wenn offensichtlich unrealistisch hohe Empfindlichkeiten gegenüber CO2 das Ergebnis der Simulationen ist, wie immer mehr Arbeiten nachweisen, nützt auch die Vervielfachung der Rechnerleistung nichts, man macht die Fehler damit nur noch schlimmer. Wenn die Physik (Feedbacks, Sonne, Wolken, interne Variabilität, Erwärmungsmuster, Ozeanströmungen etc.) nicht repliziert werden kann, werden die Irrtümer durch „Tuning“ und Parametrierung nur immer weiter aufgeblasen.

Wie viele Arbeiten erschienen, die anhand von „sophisticated climate models“ ihre Aussagen begründeten? Was für eine Verschwendung. Ist damit die bisherige „Playstation – Klimatologie“ an ihrem wohlverdienten Ende, bis man über besser funktionierende Modelle verfügt, wie sie Palmer& Stevens einfordern? Wir sind optimistisch.