Von Frank Bosse und Fritz Vahrenholt

Unsere Sonne war auch im Februar stark unternormal aktiv. Obwohl wir mitten im Minimum sind ist die festgestellte SSN (für SunSpotNumber) von 0,8 für den 123. Monat eines Zyklus sehr gering. An 26 Tagen des Monats waren keine Flecken sichtbar, nur an 2 Tagen tat sich ein wenig, symmetrisch über beide Sonnenhemisphären verteilt. Die einzig spannende Frage in diesen Zeiten: Wann ist das Minimum beendet und der 25. Zyklus bricht sich Bahn? Obwohl mit deutlich höherer Auflösung insgesamt im Februar bereits 6 Flecken des neuen Zyklus zu erkennen waren, so sind doch Abschätzungen schwierig. Der März stand wieder ganz im Zeichen von einigen Flecken des „alten“ SC24. Die Regel:“ schwächere Zyklen dauern oft länger als stärkere“ könnte also Bestand haben.

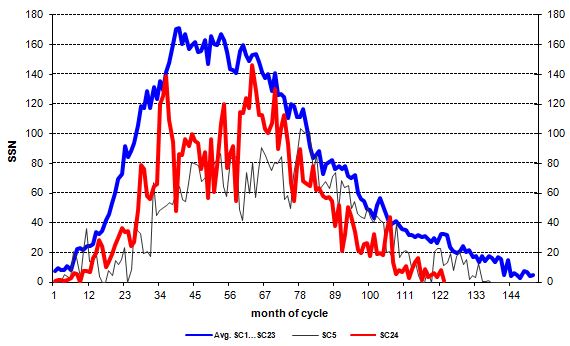

Abb.1: Die monatlich aufgelöste Fleckenaktivität der Sonne über den Solaren Zyklus (SC) 24 mit Beginn Dezember 2008 (rot) im Vergleich zu einem mittleren Zyklus, gebildet aus dem arithmetischen Mittelwert aller bisher systematisch beobachteten Zyklen 1-23 ( blau) und dem nicht unähnlichen Zyklus 5 mit Beginn Mai 1798.

Sehr gut ist das lang ausgeprägte Minimum seit Oktober 2017 ( Zyklusmonat 107) zu erkennen, die mittlere SSN betrug in diesem Zeitraum nur 7,1. Der Vergleich der Zyklen untereinander:

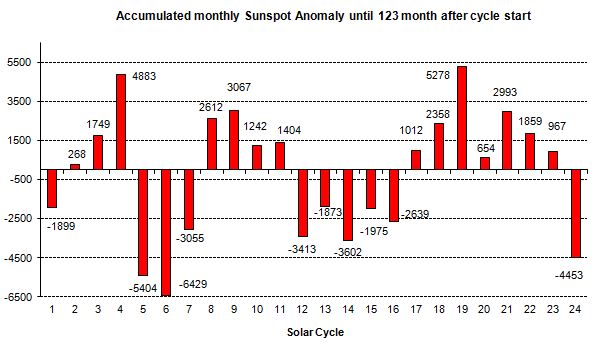

Abb.2: Die Stärke der Fleckenaktivität der einzelnen Zyklen im Vergleich. Die Zahlen im Diagramm entstehen, indem die monatlichen Abweichungen zwischen den beobachteten Werten und dem Mittelwert (blau in Abb.1) bis zum aktuellen 123. Zyklusmonat aufsummiert werden.

In Bild 2 ist zu beachten, dass fünf Zyklen (Nr. 8, 15, 16, 18, 22) überhaupt keinen Monat 123 aufwiesen, der jeweilige Folgezyklus setzte eher ein. Insofern wird das Bild jetzt zum Ende des Zyklus hin ein wenig verfälscht. Ein Blick auf die solaren polaren Felder zeigt, dass das Minimum den Höhepunkt überschritten haben könnte, beide geglätteten hemisphärischen Werte gehen zurück. Die maximale Stärke des geglätteten Mittelwertes erreichte aktuell 64 , im letzten Minimum sahen wir 55, im Minimum vor dem SC 23 war der Wert 104. Sehr viel spricht nun immer deutlicher für einen SC25, der etwas stärker als SC24 sein wird, jedoch unter der Nulllinie (für einen durchschnittlichen Zyklus in Abb.2 stehend) verbleiben wird. Sonne also weiter auf Sparflamme für weitere 12 Jahre wahrscheinlich. Die Betreiber von Satelliten und auch der ISS wird das freuen, die obere Atmosphäre dehnt sich weniger aus bei geringerer Sonnenaktivität und das spart Bahnmanöver, um die Höhe der Flugkörper zu halten.

Ein neues, aber ebenso untaugliches Klimamodell

Eine interessante Arbeit erschien unlängst, über 80 (!) Autoren waren mit von der Partie unter der Führung von Jean Christophe Golaz vom Lawrence Livermore National Laboratory. Darin wird die Entwicklung eines hochmodernen (für den kommenden 6. Sachstandsbericht des IPCC produziert) „state of the art“ Klimamodells beschrieben. In so ein Modell fließen alle verfügbaren Kenntnisse vom Verhalten von Ozean, Atmosphäre, Land, Schnee und Eis und hier sogar von Flüssen ein. Ziel ist es, die realen Verhältnisse hochgenau zu simulieren und schließlich Experimente zu unternehmen, die wir mit unserem realen Klimasystem nicht machen können. Hierfür wird viel an bekannter Physik implementiert, aber alles kann man so nicht determinieren. Es bleiben viele Parameter, die abzuschätzen und einzustellen sind, in der Modellwelt wird das „Tuning“ genannt. Wir berichteten über das übliche Vorgehen an mehreren Stellen bereits. Es wird eine Periode ausgewählt mit ausgeprägter Erwärmung (oft 1976-2005) und das Modell angepasst an die Beobachtungen der Temperaturen oder der Energiebilanz an der Oberseite der Atmosphäre. In der aktuellen Arbeit Golaz et al (2019) wurde ein anderer Weg beschritten: Es wurden die vorindustriellen Verhältnisse wie sie um 1850 herrschten, möglichst stabil über viele prä-industrielle Jahre hinweg repliziert. Auch das ist ja eine legitime Möglichkeit des „Tunings“. In einem zweiten Schritt simulierten die Forscher dann die Entwicklung u.a. der Oberflächentemperaturen von 1850 bis 2014 mit ihrem Modell und da ergab sich dann eine Überraschung:

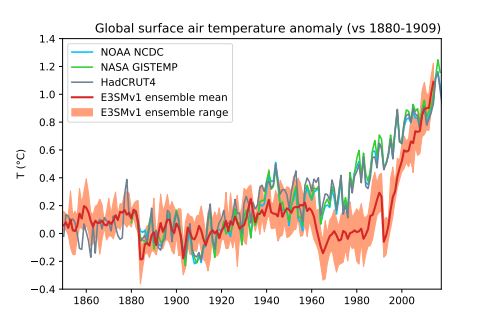

Abb. 3: Die Entwicklung der globalen Oberflächentemperaturen in Beobachtungen ( blau, grün, grau) und im Modell ( rot). Quelle: Fig. 23 aus Golaz et al. (2019).

Bis etwa 1955 schlägt sich das Modell ganz wacker mit dem „Tuning“ von 1850, wenngleich es die Erwärmung zwischen etwa 1925 und 1945 um ca. 0,4°C nicht abbildet. Danach läuft es dann aber förmlich aus dem Ruder. Wir sehen eine Absenkung im Temperaturniveau um bis zu 0,5°C bis etwa 1996, danach eine Erwärmungsrate von über 0,5°C/Dekade. Dies zeigen die Beobachtungen nicht.

Nach 1997 beträgt deren Steigung deutlich weniger als die Hälfte! Die Arbeit erklärt auch, wie es dazu kommt: Die Aerosole (sie kühlen durch Abschattung der Sonneneinstrahlung) haben eine viel zu große Wirkung im Modell und die Klimasensitivität gegenüber Treibhausgasen ist mit 5,3 °C/ Verdopplung ebenfalls deutlich zu hoch. Das erstere bewirkt die „Beule“, da die Kühlung durch menschgemachte Schwebeteilchen (vor allem SO2) in der Troposphäre zu hoch angesetzt ist und bei Nachlassen dieses negativen Antriebes (Luftreinhaltung) die große Sensitivität voll durchschlägt mit diesem explosionsartigen Anstieg der Temperaturen.

Bei anderen Klimamodellen, getunt in jüngerer Vergangenheit, sieht man den Effekt nicht so deutlich, sie wurden „eingefangen“. Hier jedoch lief das Modell mit der eigenen Physik und Parametrierung „frei“ seit 1850 und seine Unfähigkeit, die tatsächliche Entwicklung abzubilden, wird sichtbar. Andere Modelle „tarnen“ das nur, alle sind wohl nicht geeignet, frei laufend bis 2100, wirklich valide Aussagen zu liefern. Das Problem, dass Modelle eine viel zu hohe Empfindlichkeit gegenüber Treibhausgasen durch ein zu großes (negatives) Aerosolforcing kompensieren, spricht auch Björn Stevens vom Max Planck Institut für Meteorologie Hamburg (MPI) hier an.

Es scheint ein grundsätzliches Problem aller Modelle zu sein, die die natürliche Variabilität nicht hinreichend berücksichtigen und die Temperaturentwicklung allein mit anthropogenen Einflüssen erklären wollen. So kommt am Ende auch Golaz et al. (2019) zu dem Ergebnis: Beides, der (negative) Antrieb durch Aerosole und die Klimasensitivität gegenüber Treibhausgasen (insbesondere CO2) sind in Modellen zu senken, um die jüngere Vergangenheit ab 1960 mit der notwendigen Präzision zu simulieren.

Das alles erkennt man erst, wenn Modelle wie hier lange genug sich selbst überlassen werden, nicht durch ein „Tuning“ nach 1960 künstlich in Übereistimmung mit Beobachtungen gebracht werden. Für den erklärten Zweck (die Entwicklung von Szenarien bis 2100- also in etwa 80 Jahren) entpuppen sich auch die neuesten „sophisticated“ Modelle damit als ungeeignet. Sie reagieren zu empfindlich auf Aerosole, in Wahrheit das „Wundermittel“ von Modellentwicklern, um viel zu hohe Sensitivtäten gegenüber Treibhausgasen in der Gegenwart zu tarnen.

Was hält uns ab, es dem Modellierer Björn Stevens nachzutun, der zum Vergleich mit dem realen Klimasystem die Ergebnisse von Lewis&Curry (2018) heranzieht? Dort wird nicht auf 5,3°C/Verdopplung des CO2-Gehaltes der Atmosphäre geschlossen, sondern nur auf 1,7°C: Ein himmelweiter Unterschied (noch nicht einmal ein Drittel) mit Blick auf die Zukunft. Ein Wert von 5,3°C pro CO2-Verdopplung (wie es das besprochene Modell annimmt, mit seinen abstrusen Verläufen seit 1960) bedeutet ziemlich sicher die Klimakatastrophe. So abstrus wie das, was es seit 1960 „ableitete“ so abstrus wird es auch die Zukunft sehen. Schenken Sie der Empirie das Vertrauen und nicht der modellierten Katastrophe!