Von Frank Bosse und Fritz Vahrenholt

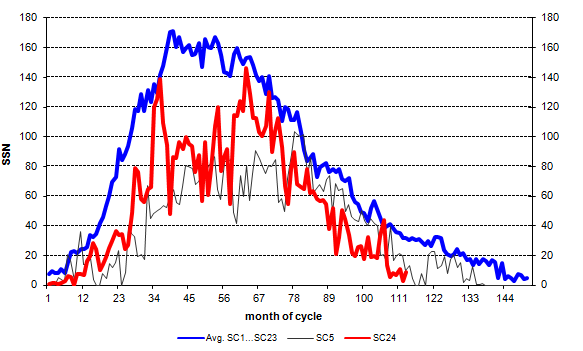

Unser Fixstern war auch im vergangenen April sehr wenig aktiv. Wir sind im Minimum zwischen dem Zyklus 24, der im Dezember 2008 begann, und dem kommenden Zyklus 25. Die festgestellte durchschnittliche SSN (SunSpotNumber) des Monats betrug 8,9, das sind 28% dessen, was für den Zyklusmonat 113 üblich ist. An 16 Tagen im April war die Sonne gänzlich fleckenlos. Etwas mehr Aktivität sahen wir zwischen dem 21. und 27.4.2018, als immerhin 2-3 Gebiete mit Störungen auf der Nordhemisphäre der Sonnenoberfläche ausgemacht wurden. Der Graph der monatlichen Zyklusaktivität:

Abb.1: Der Vergleich des aktuellen Zyklus 24 ( rot) mit einem mittleren Zyklus, gebildet aus den monatlichen Mittelwerten der bisherigen Zyklen 1.23, ( blau) und dem seit Jahren recht ähnlichen Zyklus 5 ( schwarz).

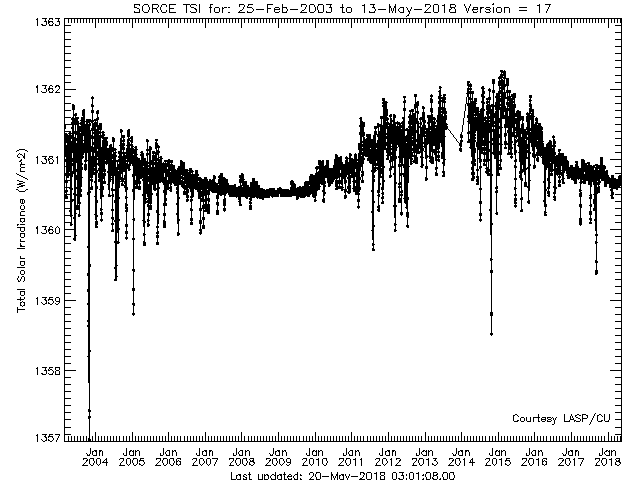

Was hier aufgezeichnet wurde, ist die Fleckenaktivität der Sonne. Mit mehr Flecken steigt auch die Leistung unseres „Fusionskraftwerkes“, wie Aufzeichnungen eines Sonnenbeobachtungssatelliten zeigen:

Abb. 2: Die Gesamtstrahlungsleistung TSI (für „Total Solar Irradience“) unsers Zentralgestirnes in mittlerer Erdentfernung seit 2004. (Quelle). Der Hub von ca. 1,5 W/m² zwischen Minimum und Maximum der Aktivität ist deutlich zu sehen, er übersetzt sich durch die Kugelform und die Drehung unserer Erde auf ca. 0,4W/m² atmosphärenwirksamer Schwankung.

Das Bild zeigt sehr schön die Zusammenhänge. Einzelne heftige Ausbrüche nach unten um mehr als 3 W/m² zeugen vom kurzen Auftreten großer Flecken, die die Oberfläche messbar verdunkeln im visuellen Bereich des Spektrums. Die naheliegende Frage:“ Warum geht die Gesamtleistung mit mehr dunklen Flecken aufwärts?“ ist nur zu beantworten, wenn man die spektralen Anteile im ultravioletten Bereich des Spektrum berücksichtigt. Parallel zum Auftauchen von dunkleren Flecken kommt es auch zu mehr Quellen an UV- Licht ( „Faculae“), die das „Dimmen“ des sichtbaren Lichtes durch Flecken überkompensieren in der Summe. Auch Abbildung 2 zeigt uns, dass wir wohl seit Beginn des Jahres 2018 im Minimum angekommen sind. Es sollte sich noch 1 bis 2 Jahre lang hinziehen wenn wir das letzte Minimum 2008 bis 2010 als Vorbild nehmen. Der längere Vergleich der Aktivität über alle systematisch beobachteten Zyklen seit 1755:

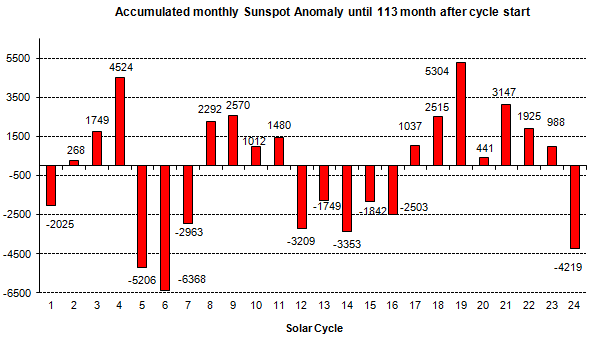

Abb.3: Die jeweils bis zum Zyklusmonat 113 monatlich aufsummierten Abweichungen vom Mittel der Aktivität der einzelnen Zyklen.

Unser aktueller Zyklus 24 nimmt den drittletzten Platz aller bisherigen Zyklen ein. Er ist insgesamt deutlich schwächer als die in der letzten längeren solaren Schwächephase 1878…1933 (Zyklus 12-16). Man muss schon zurück schauen auf die Zyklen 5 und 6 ( 1798-1823) im Dalton- Minimum, um eindeutig schwächere Zyklen in der Geschichte zu finden. Und diese Geschichte beginnt für uns erst 1755, wir wissen jedoch noch von weniger aktiven Phasen davor, etwa 1650-1700 im Maunder Minimum. Nach allen Voraussagen wird auch der nächste Zyklus Nummer 25 deutlich unternormal aktiv werden, was uns nicht überrascht: starke und schwache Zyklen, dies zeigt auch Abb.3, kommen meist in „Clustern“ vor. Die letzte Phase starker Aktivität dauerte von 1935 bis 2006.

Eine Nachlese der Diskussion um die Klimasensitivität gegenüber CO2

Wir hatten im Vormonats- Beitrag über eine neue Arbeit von Nicholas Lewis und Judith Curry ( im folgenden LC18 bezeichnet) berichtet, und zwar an ihrem Erscheinungstage im „Journal of Climate“. Sie folgert aus Beobachtungen in einem einfachen Modell, dass die Empfindlichkeit gegenüber CO2 sehr wahrscheinlich um 1,3 °C/Verdopplung des CO2- Gehaltes während der Erwärmung (TCR für Transient Climate Response) liegt und nur etwa 1,7 °C nach Einstellen eines neuen Gleichgewichtes (ECS für Equilibrium Climate Sensitivity) durch Ausgleich der Ozeane (was mehrere Jahrhunderte dauern wird) beträgt. Bemerkenswert sind beide Zahlen: am unteren Rand des IPCC-Korridors, vor allem der sehr kleine Wert für ECS sagt, dass bei weitem nicht so viel Wärme bereits in der „Pipeline“ ist, wie von Modellen (deren bester angenommener Wert hierfür ca. 3,2 °C ist) berechnet wird.

Das Vorgehen in LC18 ist völlig klar und nachvollziehbar: Es werden die berechneten Antriebe („Forcings“)mit den aktuellsten und besten Werten aus der Literatur berücksichtigt ebenso wie die globalen Temperaturen (GMST für Global Mean Surface Temperature) zu definierten Zeiträumen ausgewertet. Hinzu kommen die besten verfügbaren Daten zum Wärmeinhalt der Ozeane für die Größe ECS. Das ergibt die oben zitierten Werte, und die bedeuten auf absehbare Zeiträume keine Klimakatstrophe, selbst wenn man dem IPCC hier folgt und nahezu sämtliche aufgetretene Erwärmung seit den 1870ern dem Wirken des Menschen zuschreibt und das ist sicherlich zweifelhaft. Die heute benutzten Klimamodelle (CMIP5) kommen zu völlig anderen Ergebnissen. In der Diskussion zur Arbeit (sie war sehr intensiv geführt, vgl. hier, hier, hier) wurde von Verfechtern dieser Modelle folgende Kritikpunkte ins Feld geführt:

Woher sollen wir wissen, dass sich das irdische Klimasystem in Zukunft nicht ganz anders („natürlich“ sich viel stärker durch den CO2- Antrieb erwärmend) reagieren würde als bisher beobachtet? Es könnte doch sein, dass die bisher festgestellte vergleichsweise geringe Erwärmung durch CO2 nur eine Laune der Natur war und es viel schlimmer kommt? Es wurde weiter in den Raum gestellt, dass ein so striktes Energiebilanzmodell, wie es benutzt wurde, die Verhältnisse gar nicht so gut abbilden kann wie die viel komplizierteren GCM (für General Circulation Model).

An diesem Einwand sind mehrere Folgerungen interessant.

- Die Beobachtung einer recht niedrigen TCR, ECS wird bestätigt. Die Mittel, Methoden und Schlussfolgerungen in LC18 werden nicht angezweifelt. Das weitere Einengen der möglichen Bandbreite der Ergebnisse seit der letzten vergleichbaren Arbeit im Jahre 2014 deutet darauf hin, dass sich das Klimasystem so und nicht anders verhält, selbst wenn man das weidlich medial ausgeschlachtete ElNino- Ereignis ab 2015 einkalkuliert.

- Die Diskrepanz zwischen Modellen und beobachteter Wirklichkeit in den letzten 160 Jahren wird akzeptiert. Modelle rechnen die Welt bedeutend (um 30-45%) empfindlicher gegenüber dem CO2- Antrieb als es beobachtet wurde.

- Man verlegt das „modellgerechte“ Verhalten des realen Klimasystems immer in die Zukunft. Tenor: „Ihr werdet schon sehen…“ was für einen Naturwissenschaftler immer wenig glaubwürdig erscheinen muss.

- Je komplizierter ein Modell, desto besser muss es arbeiten: ein weit verbreiteter Irrtum.

Wie genau sind die Einwände gestrickt und warum werden sie benutzt? Eine Arbeit von Andrew Dessler und seinen Hamburger Kollegen versucht nachzuweisen, dass die natürliche Variabilität unseres Klimas ein GCM so beeinflussen kann, dass es auch über große Zeiträume hinweg trotz eigentlich höherer Sensitivität eine geringere beobachtete Empfindlichkeit „vorgaukeln“ kann. Es könnte also sein, so die Arbeit, dass uns die Natur einen Streich spielt und die Variabilität viel höher ist als bisher angenommen und die Beobachtungen mehr oder weniger wertlos für die Zukunft sind, ebenso wie die Schlussfolgerungen in LC18. So jedenfalls las es sich bei Twitter. Dem trat Nic Lewis mit einem Artikel entgegen und wies nach, dass die in der Dessler-Arbeit angesetzte Variabilität sich praktisch nicht von der beobachteten unterscheidet. Es ist am Ende doch nur das Modell, was die hohe Empfindlichkeit vorgibt.

Das nun gezogene Gegenargument: Die beobachtete räumliche Verteilung der Erwärmung ( die „spatiale Struktur“) auf der Erde muss nicht so bleiben wie beobachtet und dann wird es „natürlich“ schlimmer, es wird der „Mann mit dem Wärmehammer“ erscheinen, wenn sich die Erwärmung endlich so verhält wie es Modelle ( natürlich richtig!) vorhersagen. Auch hier wie anderswo wurde bereits darauf aufmerksam gemacht, dass die spatiale Struktur der Temperaturentwicklung in Modellen mit den Beobachtungen nur sehr schlecht übereinstimmt und die Korrelation im Mittel kaum 0,5 ist. „Kein Modell zeigt gut die regionalen Erwärmungen“. Die Folgerung der Empirie ist: „Die Modelle gehen fehl“. Sie haben auch in der Literatur bekannte Schwächen ( zu geringe Amplituden und Zeitdauern von Meeresströmungen, eine „doppelte“ innertropische Konvergenzzone, tropische ostpazifische Abweichungen etc. ) die es diesen oft mühsam „anthropogen“ parametrisierten „Kunstwerken“ nicht erlauben, ihre Erwärmungsmuster mit den beobachteten in Einklang zu bringen.

Das abenteuerliche Argument, das jetzt benutzt wurde, geht genau anders herum: Die Modelle haben recht mit ihren Mustern und in Zukunft wird sich auch die Natur daran halten müssen. Da fehlen einem wissenschaftlich denkenden Menschen schon die Worte, nicht wahr? Warum macht man so etwas? Ein prominenter Diskutant zu den Arbeiten auf einem Blog und Modellverfechter brachte es politisierend auf den Punkt als es doch eigentlich um die wissenschaftlichen Aussagen von LC 18 ging:

„Das Risiko des Ignorierens von möglicherweise wirklich schlechten Konsequenzen des Ansteigens von Treibhausgasen ist nicht akzeptabel“

Wenn die Beobachtungen nicht zu den Schreckensszenarien passen dann sind sie nicht akzeptabel! Dieser Satz sagt so viel aus über die Instrumentalisierung von Wissenschaft für politische Ziele, wir müssen nicht viel hinzusetzen. Aber Wissenschaft ist ein mächtiges Instrument, es korrigiert sich selbst, auch wenn es manchmal dauert. Eine neue Arbeit beschäftigt sich genau mit der Frage, ob jetzt vorhandene Modelle die zukünftige spatiale Struktur der Temperaturentwicklung besser antizipieren werden als sie es gegenwärtig vermögen. Die Antwort ist nein, verlasst Euch besser auf das, was beobachtet wurde. Warum? Modelle rechnen einfach die erwiesenermaßen falschen Strukturen der Gegenwart auf die Zukunft hoch, es ändert sich über die Jahre praktisch nichts. Was heute bereits falsch ist wird auch in Zukunft nicht anders.

Neben den Diskussionen in den arrivierten internationalen Foren erreichte uns auch Kritik von anderer Seite, auf die wir hier auch kurz eingehen wollen. Sie beziehen sich auf Abschätzungen einer bedeutend niedrigeren Empfindlichkeit unseres Klimas gegenüber Treibhausgasen (0,x °C/CO2 Verdopplung), oft gehen sie neuerdings auf diese Arbeit zurück. Diese wurde jedoch schon im Vorjahr widerlegt.

Was bleibt? Wer empirische Forschung für einen unverzichtbaren Teil auch von Klimawissenschaft hält, wird bis auf Weiteres von einer Klimasensitivität ausgehen müssen, die in LC 18 beschrieben ist. Sie passt auch zur Abschätzung des Unterschiedes in den GMST zwischen der letzten Eiszeit und heute. Es ist stets die Hypothese anzuwenden, die die wenigsten Rahmenbedingungen braucht, um die Natur zu erklären. Wir folgen hier der Heuristik. Wer das nicht will muss an zukünftige Katastrophen glauben, mit empirischer Wissenschaft hat dies allerdings nichts zu tun.